AI Engine: Memenuhi Permintaan Komputasi Aplikasi Generasi Berikutnya

Di banyak pasar yang dinamis dan berkembang, seperti seluler 5G, pusat data, otomotif, dan industri, aplikasi mendorong peningkatan akselerasi komputasi namun tetap hemat daya.Karena Hukum Moore dan Dennard Scaling tidak lagi mengikuti jalur tradisionalnya, peralihan ke node silikon generasi berikutnya saja tidak dapat memberikan manfaat berupa daya dan biaya yang lebih rendah dengan kinerja yang lebih baik, seperti pada generasi sebelumnya.

Menanggapi peningkatan non-linear dalam permintaan aplikasi generasi mendatang, seperti beamforming nirkabel dan inferensi pembelajaran mesin, AMD telah mengembangkan teknologi pemrosesan inovatif baru, AI Engine, sebagai bagian dari arsitektur Versal Adaptive Compute Acceleration Platform (ACAP) .

rsitektur Mesin AI

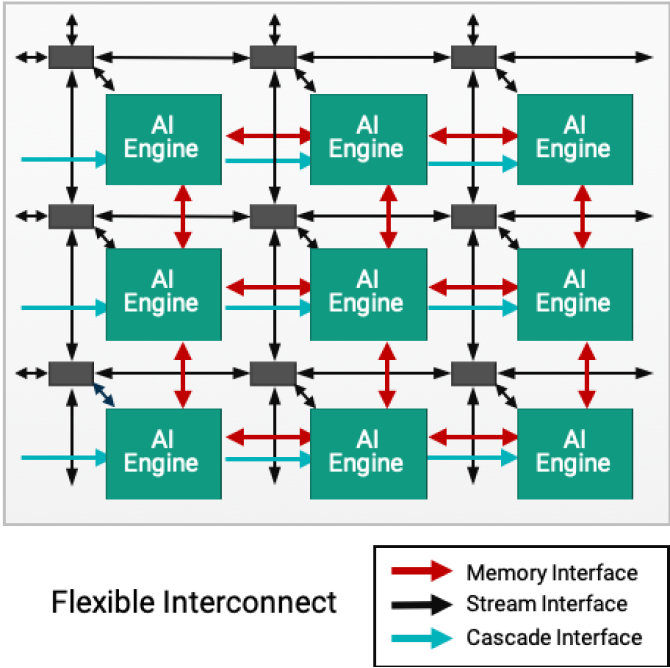

AI Engine dirancang sebagai susunan 2D yang terdiri dari beberapa ubin AI Engine dan memungkinkan solusi yang sangat skalabel di seluruh portofolio Versal, mulai dari 10 hingga 100 AI Engine dalam satu perangkat, melayani kebutuhan komputasi berbagai aplikasi.Manfaatnya antara lain:

Kemampuan Pemrograman Perangkat Lunak

- C dapat diprogram, kompilasi dalam hitungan menit

- Desain berbasis perpustakaan untuk pengembang kerangka ML

deterministik

- Instruksi khusus dan memori data

- Konektivitas khusus yang dipasangkan dengan mesin DMA untuk pergerakan data terjadwal menggunakan konektivitas antar ubin AI Engine

Efisiensi

- Menghadirkan kepadatan komputasi area silikon hingga 8X lebih baik jika dibandingkan dengan implementasi DSP dan ML logika terprogram tradisional, sehingga mengurangi konsumsi daya sebesar 40%

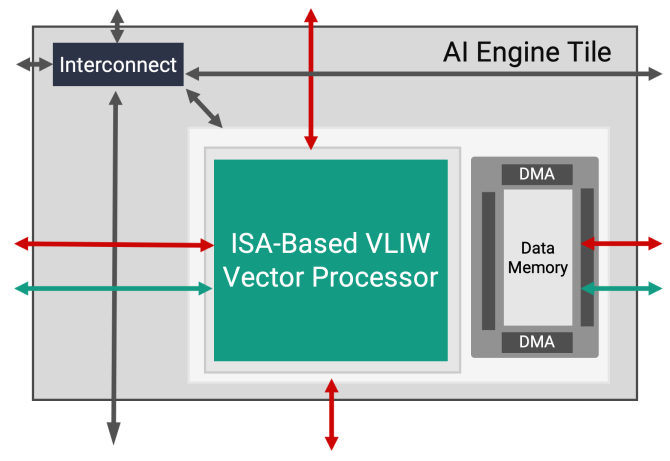

Ubin Mesin AI

Setiap ubin AI Engine terdiri dari prosesor vektor VLIW, (Kata Instruksi Sangat Panjang), SIMD, (Single instruction Multiple Data) yang dioptimalkan untuk pembelajaran mesin dan aplikasi pemrosesan sinyal tingkat lanjut.Prosesor AI Engine dapat berjalan hingga 1,3GHz sehingga memungkinkan fungsi yang sangat efisien, throughput tinggi, dan latensi rendah.

Seperti halnya prosesor VLIW Vector, setiap ubin berisi memori program untuk menyimpan instruksi yang diperlukan;memori data lokal untuk menyimpan data, bobot, aktivasi dan koefisien;prosesor skalar RISC dan mode interkoneksi berbeda untuk menangani berbagai jenis komunikasi data.

Beban Kerja Heterogen: Pemrosesan Sinyal dan Akselerasi Inferensi Pembelajaran Mesin

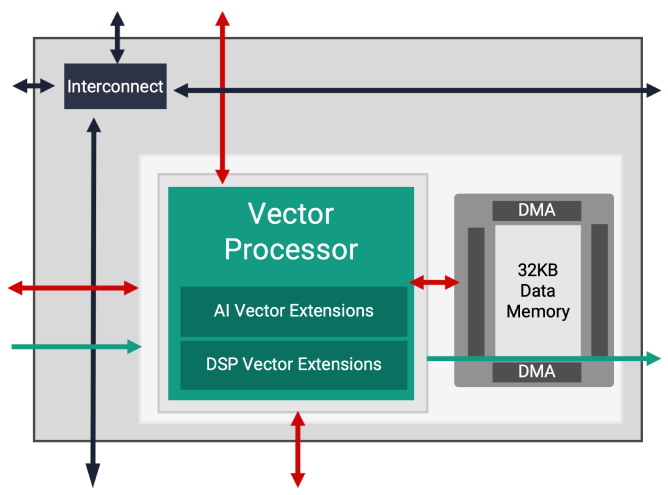

AMD menawarkan dua jenis Mesin AI: AIE dan AIE-ML (AI Engine for Machine Learning), keduanya menawarkan peningkatan kinerja yang signifikan dibandingkan FPGA generasi sebelumnya.AIE mempercepat serangkaian beban kerja yang lebih seimbang termasuk aplikasi ML Inference dan beban kerja pemrosesan sinyal tingkat lanjut seperti beamforming, radar, dan beban kerja lainnya yang memerlukan pemfilteran dan transformasi dalam jumlah besar.Dengan ekstensi vektor AI yang ditingkatkan dan pengenalan ubin memori bersama dalam rangkaian AI Engine, AIE-ML menawarkan kinerja yang unggul dibandingkan AIE untuk aplikasi yang berfokus pada inferensi ML, sedangkan AIE dapat menawarkan kinerja yang lebih baik dibandingkan AIE-ML untuk jenis pemrosesan sinyal tingkat lanjut tertentu.

Ubin Mesin AI

AIE mempercepat serangkaian beban kerja yang seimbang termasuk aplikasi ML Inference dan beban kerja pemrosesan sinyal tingkat lanjut seperti beamforming, radar, FFT, dan filter.

Dukungan untuk banyak beban kerja/aplikasi

- DSP tingkat lanjut untuk komunikasi

- Pemrosesan video dan gambar

- Inferensi Pembelajaran Mesin

Dukungan asli untuk tipe data floating point yang nyata, kompleks

- titik tetap INT8/16

- CINT16, titik tetap kompleks CINT32

- Titik data mengambang FP32

Fitur HW khusus untuk implementasi FFT dan FIR

- 128 INT8 MAC per ubin

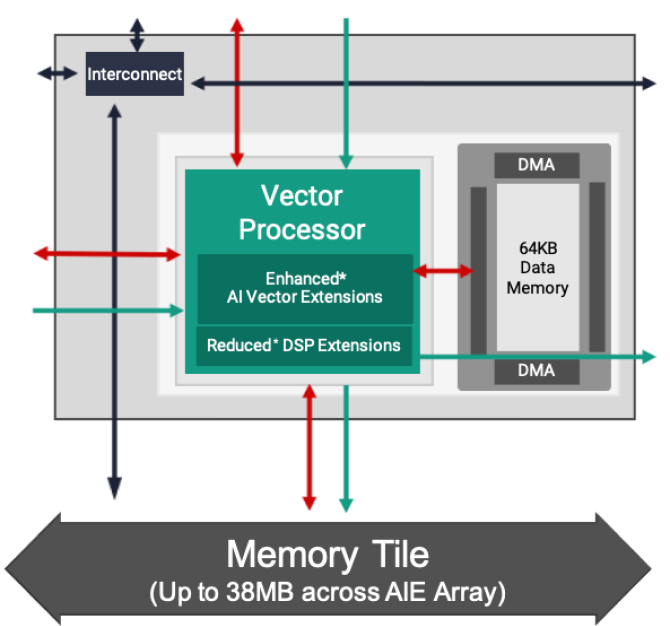

Ubin Mesin AI-ML

Arsitektur AI Engine-ML dioptimalkan untuk pembelajaran mesin, meningkatkan arsitektur inti komputasi dan memori.Mampu melakukan ML dan pemrosesan sinyal tingkat lanjut, ubin yang dioptimalkan ini tidak menekankan dukungan INT32 dan CINT32 (umum dalam pemrosesan radar) untuk menyempurnakan aplikasi yang berfokus pada ML.

Dukungan asli yang diperluas untuk tipe data ML

- INT4

- BFLOAT16

Komputasi ML 2X dengan latensi lebih rendah

- 512 INT4 MAC per ubin

- 256 INT8 MAC per ubin

Peningkatan memori array untuk melokalisasi data

- Memori data lokal dua kali lipat per ubin (64kB)

- Ubin memori baru (512kB) untuk akses memori bersama B/W yang tinggi